Ce que vous n’avez pas le droit de faire sans autorisation en cybersécurité

La cybersécurité est un domaine mêlant technologie, stratégie et aspects légaux. Protéger ses systèmes informatiques est non seulement un droit, mais une obligation pour les individus et les organisations. Cependant, tester des vulnérabilités, manipuler des données ou exploiter des technologies comme l'intelligence artificielle (IA) sans autorisation peut vite vous faire franchir la ligne de l'illégalité. Avec l'essor de la biométrie, de la collecte massive de données personnelles et des outils d'IA, les risques se multiplient, et les frontières entre curiosité technique et infraction deviennent parfois floues.

Pourtant, les lois, en France et en Europe, sont claires et strictes. Le Code pénal français, le Règlement général sur la protection des données (RGPD) et d'autres textes encadrent ces pratiques pour protéger la vie privée, la sécurité nationale et l'intégrité des systèmes. Outrepasser ces règles expose à des sanctions pénales, administratives et financières lourdes, pouvant aller jusqu'à des années de prison ou des amendes atteignant des millions d'euros.

1. L’accès non autorisé aux systèmes informatiques

L'accès non autorisé à un système informatique est l'une des infractions les plus fondamentales en cybersécurité. Selon l'article 323-1 du Code pénal français, le fait d'accéder ou de se maintenir frauduleusement dans tout ou partie d'un système de traitement automatisé de données (STAD) est puni de trois ans d'emprisonnement et de 100 000 euros d'amende. Ce délit ne nécessite pas de causer un dommage visible ; la simple intrusion suffit.

Le terme "frauduleusement" implique une intention malveillante ou une tromperie, comme l'utilisation de fausses identités ou de faiblesses techniques sans permission.

Pourquoi est-ce si grave ? Les systèmes informatiques stockent des données sensibles : informations financières, médicales ou stratégiques. Un accès non autorisé peut mener à des fuites massives, comme dans les cas de piratage d'entreprises où des hackers ont volé des données clients sans altérer les systèmes.

Plus concretement, tenter de deviner un mot de passe pour accéder à un compte email professionnel, même par simple curiosité, tombe sous le coup de la loi. De même, scanner les ports d'un site web d'une entreprise pour détecter des vulnérabilités, sans un contrat écrit, peu déjà être considéré comme une intrusion.

Dans la pratique, les sanctions peuvent être aggravées. Si l'intrusion est commise en bande organisée, la peine monte à dix ans d'emprisonnement et 300 000 euros d'amende.

Pour éviter cela, les professionnels doivent toujours obtenir une autorisation écrite avant tout test. Les particuliers, quant à eux, devraient s'abstenir de toute exploration non sollicitée. En résumé, même une action "inoffensive" comme vérifier la sécurité d'un Wi-Fi public peut virer au délit si elle implique un accès non consenti. La loi protège ainsi l'intégrité des systèmes, et les tribunaux appliquent ces règles avec rigueur pour dissuader les cybercriminels potentiels.

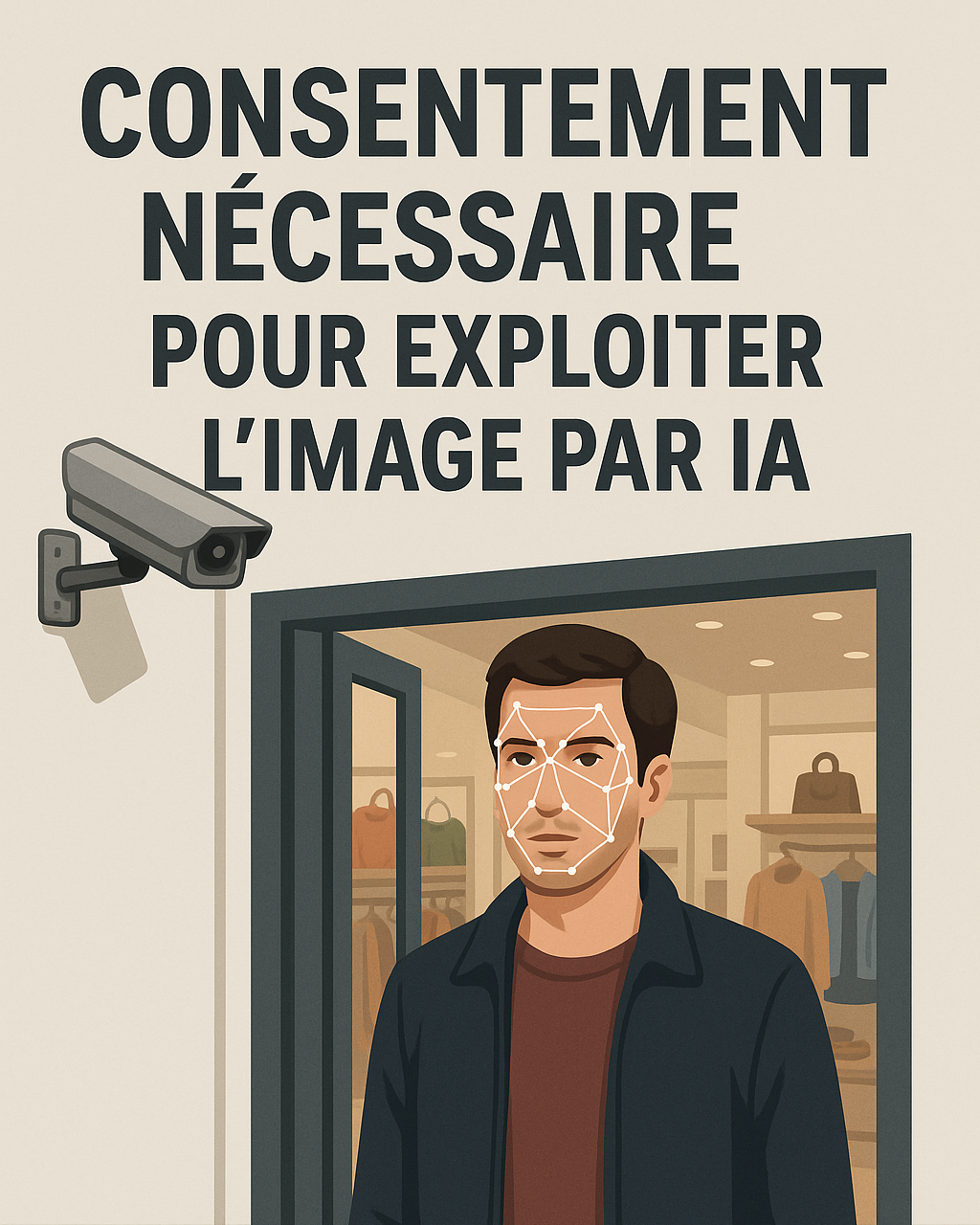

2. L’exploitation de la biométrie sans consentement

Les données biométriques – empreintes digitales, reconnaissance faciale, vocale ou iris – sont parmi les plus sensibles, car elles identifient une personne de manière unique et permanente. Le RGPD, applicable en Europe depuis 2018, les classe comme données "sensibles" à l'article 9, interdisant leur traitement sauf exceptions limitées, comme un consentement explicite ou des motifs d'intérêt public (sécurité nationale, santé). Sans cela, collecter, stocker ou utiliser ces données est illégal, avec des sanctions pouvant atteindre 20 millions d'euros ou 4 % du chiffre d'affaires mondial de l'entreprise.

Pourquoi cette protection renforcée ? Contrairement à un mot de passe, une donnée biométrique ne peut être changée si compromise. Une fuite peut mener à des usurpations d'identité permanentes. En France, la CNIL (Commission nationale de l'informatique et des libertés) veille à l'application du RGPD et a déjà sanctionné des violations.

Exemples concrets d'interdits : Utiliser des photos publiques sur internet pour entraîner un système de reconnaissance faciale, comme l'a fait Clearview AI, condamné à plusieurs reprises en Europe pour violation du RGPD. Ou collecter les empreintes vocales lors d'appels clients pour "améliorer" un assistant virtuel sans leur informer et obtenir un consentement libre. Le consentement doit être granulaire, révocable et non forcé – par exemple, un employé ne peut être contraint d'utiliser la biométrie pour pointer sans alternative.

Les entreprises doivent implémenter des mesures strictes : évaluation d'impact sur la protection des données (EIPD), chiffrement et limitation des usages. En cas de violation, les sanctions administratives s'ajoutent aux pénales potentielles. Un cas emblématique : en 2022, Accor a été sanctionné de 600 000 euros pour manquement au consentement dans des traitements similaires. Pour les particuliers, scanner des visages via une application sans permission est aussi risqué.

En conclusion, respectez toujours le principe de minimisation : n'utilisez la biométrie que si nécessaire et avec autorisation. Cela protège non seulement contre les sanctions, mais renforce la confiance des utilisateurs.

3. L’utilisation des données personnelles pour entraîner une IA

L’essor des IA génératives comme ChatGPT a entraîné une multiplication des tentatives d’exploitation de données personnelles pour l’entraînement des modèles. Or, le RGPD encadre strictement ces usages : il interdit toute utilisation de données personnelles sans base légale solide, telle qu’un consentement explicite ou un intérêt légitime dûment justifié. Les données personnelles concernées incluent les adresses email, les historiques de navigation, les profils sociaux ou professionnels, y compris ceux accessibles publiquement sur des plateformes comme LinkedIn, qui demeurent protégés par le droit.

Les risques associés à un entraînement non conforme sont multiples. Une IA alimentée par des données collectées sans consentement peut reproduire et amplifier des biais, générer des discriminations ou encore divulguer des informations sensibles. Ces pratiques exposent également les entreprises à des sanctions financières considérables : jusqu’à 4 % du chiffre d’affaires mondial, comme l’ont déjà expérimenté des acteurs tels que Meta ou Google. OpenAI elle-même a été sanctionnée par l’autorité italienne à hauteur de 15 millions d’euros pour avoir entraîné ChatGPT sur des données personnelles sans consentement adéquat.

En France, la CNIL a publié des lignes directrices précisant que tout modèle d’IA susceptible de mémoriser des données personnelles relève du champ d’application du RGPD. Cela impose la mise en œuvre de mesures d’anonymisation ou de pseudonymisation. Plusieurs cas concrets illustrent ces dérives : une entreprise française a été condamnée pour avoir collecté et exploité sans base légale des profils LinkedIn, en violation du droit à l’oubli. De même, nourrir un chatbot avec des conversations clients pour “l’améliorer” sans en informer ni obtenir l’accord des utilisateurs constitue une infraction. La gravité est encore accrue lorsque des données sensibles sont impliquées, comme celles relatives à la santé ou aux opinions.

Pour se conformer à la loi, il est impératif de réaliser une EIPD (étude d’impact sur la protection des données) avant tout projet d’entraînement, d’assurer la traçabilité complète des jeux de données, et de garantir aux personnes concernées l’exercice de leurs droits, notamment le droit à l’effacement. Cela peut nécessiter de réentraîner entièrement le modèle, une opération complexe et coûteuse. L’utilisation de datasets anonymisés ou provenant de sources open data conformes au droit constitue une alternative sécurisée. À défaut, les biais persistants dans les données d’entraînement peuvent conduire à des discriminations supplémentaires, augmentant le risque de sanctions.

En définitive, l’intelligence artificielle ne justifie en rien les atteintes aux droits fondamentaux ; au contraire, elle peut en amplifier les conséquences. Les entreprises doivent intégrer le RGPD dès la conception de leurs systèmes (privacy by design) afin de prévenir les risques juridiques, éviter des amendes massives et protéger leur réputation.

4. Les attaques par IA et l’automatisation de la cybercriminalité

L’intelligence artificielle transforme profondément le paysage de la cybercriminalité en rendant les attaques plus massives, plus crédibles et techniquement plus sophistiquées. Les outils d’IA permettent par exemple de générer des campagnes de phishing indiscernables, de produire des deepfakes convaincants ou encore de concevoir du code malveillant. Ces usages sont strictement interdits : en droit français, ils relèvent de la fraude ou de l’usurpation d’identité, et tombent sous le coup du Code pénal. La loi ne distingue pas l’outil employé : un phishing généré par IA reste une fraude punissable, passible de cinq ans d’emprisonnement et de 375 000 euros d’amende.

Les deepfakes représentent une menace particulière pour la réputation et la stabilité économique. Une vidéo falsifiée mettant en scène un dirigeant d’entreprise peut, à elle seule, provoquer une panique médiatique ou des fluctuations boursières importantes. Face à ce type de danger, le législateur a renforcé le cadre juridique : la loi SREN de 2024 prévoit des sanctions aggravées en cas de cyberharcèlement facilité par des technologies d’intelligence artificielle.

Dans le domaine professionnel, il peut être nécessaire de manipuler ces outils à des fins de test ou d’analyse. Toutefois, cela doit se faire dans un cadre strictement encadré, avec des environnements isolés et des règles éthiques claires, afin d’éviter tout détournement ou toute diffusion non contrôlée.

En définitive, l’IA agit comme un amplificateur des risques numériques. Mais parallèlement, l’évolution du droit vise à punir sévèrement les abus et à protéger la société numérique. La vigilance, la conformité légale et l’intégration de l’éthique demeurent des conditions essentielles pour contenir ces nouvelles menaces.

5. Le piratage éthique : seulement avec autorisation écrite

Le "piratage éthique" ou pentest (test d'intrusion) est légal uniquement avec une autorisation écrite et un contrat définissant le périmètre. Sans cela, c'est une intrusion illégale, punie comme telle (jusqu'à 3 ans de prison).

Des plateformes comme YesWeHack ou HackerOne gèrent des bug bounties (chasses aux bugs) légaux, où des hackers testent des systèmes avec accord des entreprises. En France, le programme FranceConnect bug bounty permet des tests sur l'identité numérique gouvernementale. Un pentest sans contrat, même "pour aider", reste illégal.

6. Le partage ou la revente de vulnérabilités

Découvrir une vulnérabilité peut être bénéfique pour la sécurité numérique, mais la partager publiquement ou la revendre en dehors d’un cadre légal constitue une infraction. Ces pratiques sont assimilées à du trafic d’armes numériques et relèvent du droit pénal. La démarche correcte consiste à signaler la faille à l’éditeur concerné par le biais de canaux officiels ou de programmes de bug bounty, afin de laisser le temps nécessaire à la correction avant toute publication.

À l’inverse, mettre en vente une vulnérabilité sur le dark web ou la céder à des acteurs malveillants expose à des sanctions lourdes : en France, la peine peut atteindre cinq ans d’emprisonnement et 150 000 euros d’amende. La législation française, loin de décourager les chercheurs en sécurité, promeut au contraire la divulgation responsable. Cette approche vise à renforcer la confiance numérique et à réduire les risques d’exploitation criminelle des failles découvertes.

7. L’espionnage, même passif, est interdit

La surveillance des emails et le cadre légal

L’espionnage passif, c’est-à-dire l’interception ou la consultation de communications ou d'informations sans modification, est interdit par la loi.

En France, le Code pénal (articles 226-15 et 323-1 notamment) sanctionne la collecte frauduleuse de correspondances privées : jusqu’à 5 ans d’emprisonnement et 300 000 euros d’amende.

Dit autrement, lire un email qui ne vous est pas destiné, sans motif légitime et encadrement juridique, est un délit.

Le cas du DLP (Data Loss Prevention) en entreprise

Les entreprises peuvent mettre en place des systèmes de DLP pour prévenir les fuites de données sensibles. Mais cela n’autorise pas pour autant la lecture libre du contenu des emails des salariés.

- Les procédures doivent être écrites, strictes et proportionnées (par exemple une charte informatique validée par le CSE et intégrée au règlement intérieur).

- La surveillance doit respecter le principe de proportionnalité du RGPD et du Code du travail : on ne peut pas contrôler plus que nécessaire.

- La CNIL impose que les salariés soient informés en amont des dispositifs de surveillance mis en place (charte, note de service, etc.).

Lecture du contenu d’un email : avec ou sans prévenir ?

Un employeur peut accéder à un email professionnel si cela est justifié par les intérêts légitimes de l’entreprise (sécurité, conformité réglementaire, enquête interne).

En revanche, si l’email est identifié comme “personnel” ou “privé” (mention dans l’objet ou classement dans un dossier dédié), l’employeur n’a pas le droit d’y accéder sans l’autorisation du salarié.

Lorsqu’un accès exceptionnel au contenu est nécessaire (par exemple suspicion de fuite de données), cela doit se faire dans un cadre documenté, justifié et traçable.

Il n’est pas obligatoire de prévenir le salarié avant la consultation, mais il doit avoir été informé en amont de l’existence et des règles du dispositif de surveillance. Dans le cadre d’un contrôle individuel, le salarié doit pouvoir être informé a posteriori, afin d’assurer la transparence et de respecter le droit à la vie privée.

Conclusion

La cybersécurité n’est pas un espace sans règles : elle est encadrée par des lois destinées à protéger la confiance numérique. Des dispositifs légaux existent pour permettre les pratiques de test ou de recherche en toute légitimité. Les tests d’intrusion doivent être réalisés dans le cadre de contrats de pentest clairement établis. Les programmes de bug bounty, proposés par des plateformes spécialisées comme YesWeHack, offrent un cadre sécurisé aux chercheurs.

De même, l’utilisation de jeux de données ouverts pour l’entraînement d’IA est possible, à condition de respecter scrupuleusement les licences associées. Enfin, les environnements de type sandbox permettent d’expérimenter ou de tester des outils de manière isolée et contrôlée.

En dehors de ces cadres autorisés, toute action non validée expose à des sanctions pénales et financières sévères.

Le respect de l’éthique et de la légalité demeure donc la seule voie pour contribuer à un espace numérique fiable et sécurisé.